Hand aufs Herz: Egal, wie gut die Fremdsprachenkenntnisse auch sind, so ist es ab und zu wirklich hilfreich, einen Satz in ein Übersetzungstool wie DeepL oder Google Translate zu tippen und sich eine maschinelle Übersetzung liefern zu lassen, oder? Das Problem: Wer sich in der jeweiligen Fremdsprache nicht gut auskennt, der merkt wahrscheinlich auch nicht, wenn das KI-Werkzeug Ergebnisse liefert, die jedem Muttersprachler die Haare zu Berge stehen lassen. Ein Beispiel ist das vielfach diskutierte Thema „Gender“. Hier zeigt sich deutlich, warum maschinelle Übersetzungslösungen in einigen Fällen zwar nützlich, in anderen aber überaus fehleranfällig sein können.

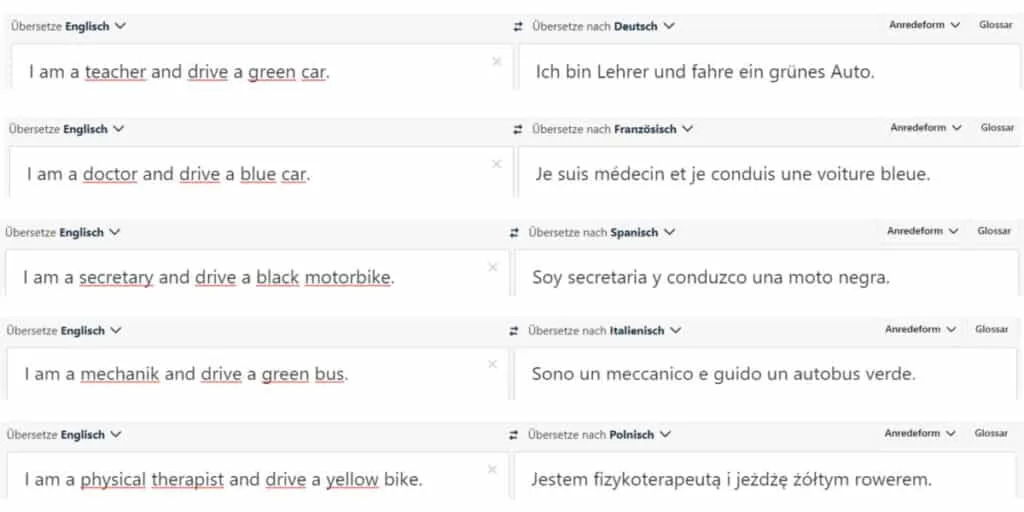

Wer etwa Sätze wie „I visited a doctor yesterday“ eingibt, erhält automatisch „Ich war gestern beim Arzt“. Soll heißen: „DeepL“ und andere Tools halten scheinbar nicht viel von Emanzipation und Gleichberechtigung. Berufe werden automatisch „gegendert“, also einem „typischen“ Geschlecht zugeordnet. Wir von ACT Translations haben es einmal mit den verschiedensten Berufen und Sprachen ausprobiert, kamen aber immer wieder zu recht ernüchternden Ergebnissen. Eine „Nurse“ ist automatisch eine „Krankenschwester“, auch wenn der englische Begriff „Nurse“ durchaus auch für männliche Pfleger gebräuchlich ist. Ein „Mechanic“ wird mit „Mechaniker“, „mecánico“ oder „mécanicien“ übersetzt, ein „Physical Therapist“ wird „Physiotherapeutin“. Der Professor ist, wen wundert’s, männlich, „Housekeeper“ hingegen typisch weiblich.

KI-Branche weiß, männlich und wenig divers

Sind Deep Learning, Maschinelles Lernen oder KI also per se testosterongetriebene Macho-Systeme? Oder woran liegt es, dass die Tools keine „Ärztin“ oder „KFZ-Mechanikerin“ vorschlagen? Die Antwort ist vielschichtig. Zum einen wird das Forschungsgebiet der künstlichen Intelligenz dominiert von weißen, männlichen Wissenschaftlern. Laut MIT Technologie Review sind bei führenden KI-Konferenzen nur 18 Prozent der geladenen Sprecher Frauen, nur 20 Prozent der KI-Professoren und nur zehn Prozent der wissenschaftlichen Mitarbeiter bei Facebook oder Google sind weiblich. Das ist aber nur ein kleiner Aspekt eines größeren Problems.

KI basiert auf Unmengen von Daten

Maschinelle Lern-Systeme können außer Frage leistungsfähige Werkzeuge sein, aber sie sind immer nur so gut wie die Daten, mit denen sie gefüttert werden. Ist also ein systematischer Fehler in den Daten, die zum Trainieren eines maschinellen Lernalgorithmus verwendet werden, wird das resultierende Modell dies widerspiegeln.

In den meisten Fällen geht es schlichtweg nicht um Voreingenommenheit oder Stereotypen. Es hängt auch nicht mit den Menschen zusammen, die vielleicht bei der Auswahl ihrer Datensätze oder beim Training ihrer Modelle oberflächlich vorgegangen sind. Nein, in den Ergebnissen der maschinellen Übersetzungen manifestieren sich inhärente gesellschaftliche Verzerrungen, so ähnlich wie historische Aufzeichnungen einer Gesellschaft, Schlaglichter der Gesamtsituation. Diese Datensätze wiederum geben ihre Voreingenommenheit, beziehungsweise Oberflächlichkeit, an die maschinellen Lernmodelle weiter, die aus ihnen lernen. Waren in der Vergangenheit mehr Männer als Frauen Ärzte, wird ein maschinelles Lernmodell, das auf historischen Daten trainiert wurde, lernen, dass Ärzte mit größerer Wahrscheinlichkeit männlich als weiblich sind, unabhängig von der aktuellen Geschlechterverteilung unter den Ärzten.

Typische Sprachmuster statt Kontext

Maschinelle Übersetzungsmodelle werden mithilfe riesiger Textzusammenhänge trainiert. Unter ihnen befinden sich auch Satzpaare, die schon einmal übersetzt wurden. Hinzukommen Nuancen einer Sprache, die es oft erschweren, eine genaue und direkte Übersetzung zu liefern. Bei der Übersetzung vom Englischen in Sprachen wie Deutsch, Französisch oder Spanisch werden einige geschlechtsneutrale Substantive in geschlechtsspezifische Substantive übersetzt. Ist ein „Friend“ im Englischen geschlechtsneutral, wird der Begriff auf Spanisch „amiga“ (feminin) oder „amigo“ (maskulin). Ein menschlicher Übersetzer kann nachfragen: Ist ein Mann oder eine Frau gemeint? Das maschinelle Übersetzungstool kann diesen Kontext nicht erfragen.

Herausforderung Kommunikation und gesprochenes Wort

Richtig kompliziert wird es, wenn maschinelle Tools für die Übersetzung von Reden und Co. eingesetzt werden. In der gesprochenen Sprache können Intonation, Mimik, Wiederholungen und Sarkasmus oder Ironie die Bedeutung eines Satzes völlig verändern. Moderne maschinelle Übersetzungslösungen erfassen derartige Nuancen nicht genau. Hinzukommen weitere Beispiele, bei denen Übersetzungstools an ihre Grenzen stoßen. Wer etwa „Cream of Tartar“ (eine Art Backpulver) in Google Translate eingibt, erhält die wortwörtliche Übersetzung „Sahne von Zahnstein“. Aus „Kernseife“ wurde vor einigen Jahren noch „Nuclear Soap“. Doch hier hat das System mittlerweile dazugelernt und übersetzt mittlerweile mit „curd soap“.

Neuronale Netze statt statistischer Methoden

Derartige Übersetzungsfehler lassen sich damit erklären, dass Google Translate etwa viele Jahre mit statistischen Übersetzungsmethoden gearbeitet hat, die Wort für Wort vorgingen und keine Zusammenhänge erkannten. Solche Fails sind heute weitaus seltener als noch vor ein paar Jahren, da Google Translate jetzt bei vielen der mehr als 100 Sprachen im Angebot auf neuronale Netze, also künstliche Intelligenz, setzt, um Kontext genauer zu erfassen. Wissenschaftler arbeiten mit Hochdruck auch an der Gender-Herausforderung.

Sprachgefühl gefragt

Ohne Frage: Maschinen arbeiten wunderbar mit strukturierter Sprache für bestimmte Anwendungen. Beispiele sind Wetterberichte, Finanzberichte, Regierungsprotokolle oder Sportergebnisse. Es gibt aber viele Bereiche, bei denen die smarten Werkzeuge an ihre Grenzen stoßen und menschliche Übersetzer und Sprachkenner ans Werk müssen. Wer schon einmal versucht hat, einen schmissigen Marketing-Text maschinell zu übersetzen, sieht schnell: Das funktioniert nicht! So verstand so mancher Parfümerie-Kunde beim Douglas-Slogan „Come in and find out“ nicht „Kommen Sie herein und finden Sie es heraus“ sondern „Finden Sie rein und wieder raus“. Auch Rechtstexte sollten besser von Experten als von Maschinen übersetzt und dann noch einmal Korrektur gelesen werden, um Missverständnisse oder gar Klagen zu vermeiden.

The interplay of human and machine

Auch wenn maschinelle Übersetzungstools in den vergangenen Jahren immer besser und genauer geworden sind und sich viele Studien mit genderspezifischen Herausforderungen diesbezüglich beschäftigen, gibt es auf diesem Gebiet noch enormen Nachholbedarf – wie im gesamten Bereich der Gender-Forschung und Gleichberechtigung. Wie gut, dass menschliche Übersetzer über das notwendige Sprach- und Fingerspitzengefühl verfügen, um Schützenhilfe zu leisten. Und gegen ein gutes Zusammenspiel zwischen Mensch und Maschine ist nichts einzuwenden, oder?